Motivation

目前的研究主要集中在训练阶段,对解码过程本身的研究仍停留在贪心和 beam search 的阶段。

本文提出 trainable greedy decoding 的概念,针对解码目标、翻译模型不唯一的问题,设计了一个通用的解码算法。该算法能在翻译模型已经训练完成的基础上,针对不同的解码目标(不仅是 log-probability)进行训练。

Methods

Trainable Greedy Decoding

作者从 noisy, parallel approximate decoding (NPAD) algorithm 得到启发,该算法在计算 hidden states 时,对每个隐状态加入一个高斯噪音,得到了 log-probability 更高的翻译结果。作者认为这一结果说明对 hidden state 进行操作能够找到一个渐进复杂度不变却能得到更好结果的解码算法。

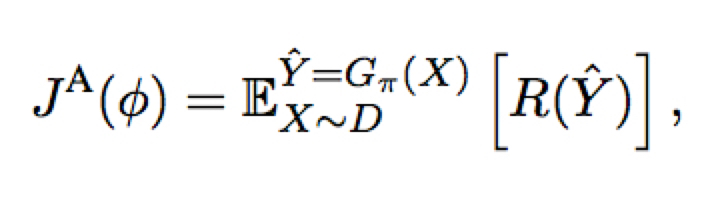

作者将它的算法称为 agent $\pi$ ,其参数记为 $\phi$,则训练目标为

其中 R 为任意的解码目标

优化这个训练目标主要有两个难点:

- R的任意性可能使得其不可微,如 BLEU

- agent 是一个实值的,action space 维数非常高的确定性策略

Deterministic Policy Gradient

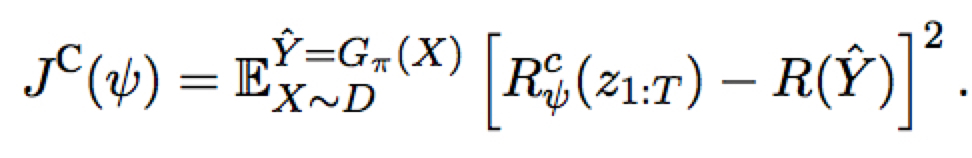

使用参数化的可微分的逼近 -> critic $R^c$,通过最小化下面的目标来训练 $R^c$,其中 $z_{1:T}$ 为经过 agent 修改过的隐状态

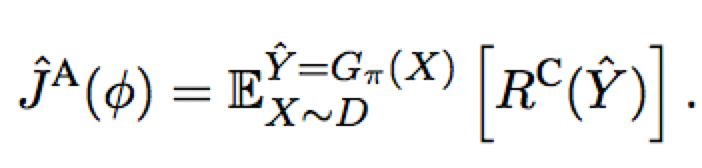

而有了 $R^c$,我们就可以将学习目标转为最大化解码目标的逼近目标 $R^c$

注:上面两个目标同时进行训练

需要RL的知识,以后有机会再读